Ga ik

nu echt met pensioen? Het merendeel van de journalisten beheerst

tegenwoordig het bekende Excel spreadsheet en het maken van een

grafiek of een kaartje met bijvoorbeeld Tableau of Plotly. In

Tanzania by Mwananchi (Citizen) of Habari Leo (Daily

News), werken journalisten met deze standaardtools. Het probleem is

alleen dat de overheid de krant een verschijningsverbod oplegt als

de cijfers niet passen in het overheidsbeleid. En als je niet op past

beland je achter de tralies.

R in

de mode

Trainingen

voor financieel-economisch journalisten, tijdens Highway Africa

Barclays/ABSA training, leerde mij dat we verder moeten gaan dan dit

standaardgereedschap. Bij deze meer gespecialiseerde journalisten is

belangstelling voor meer statistisch achtergrond bij de data. R is

daarbij een goede start:

https://www.denieuwereporter.nl/2014/04/vijf-redenen-om-r-te-gebruiken-in-datajournalistiek/

Binnen

de datajournalistiek is R 'hot'. In trainingen van the IRE zit

standaard een module over werken met R.

The

Economist besloot onlangs analyse van data en visualisaties ,

gemaakt in R, the publiceren op Github. Je kunt ze gemakkelijk

downloaden en zo zelf de analyse opniew uitvoeren. De Big Mac

Index is een aardig voorbeeld(

https://github.com/TheEconomist/big-mac-data

) Economische data voor Sub Sahara Africa ontbreken bij de

Economist. Een aardige trainingsopdracht was die data te vinden en

vervolgens een Big Mac Index te berekenen voor Sub Sahara Africa.

Ook

de BBC besloot meer aandacht aan R te schenken; in het

bijzonder visualisering met

R(https://medium.com/bbc-visual-and-data-journalism/how-the-bbc-visual-and-data-journalism-team-works-with-graphics-in-r-ed0b35693535

)

Een

analyse in R is eigenlijk een klein programmaatje; een serie

opdrachten vanaf de command prompt. Dus een Big Mac Index is dus een

stukje code in R. Omdat dit te delen met anderen, gebruikt je een

jupyter-notebook formaat

(https://d3-media.blogspot.com/2017/09/jupyter-notebook.html

) . Ook de Economist biedt dit soort notebooks aan om hun

berekeningen te volgen. In een training staan de belangrijkste

stappen voor de index al genoteerd in zo'n notebook. Na het invoeren

van de data door de deelnemers volgt de berekening van de index en de

visualisaties.

Model

en voorspelling

Financieel-economisch

journalisten zijn vooral geinteresseerd in verbanden tussen

variabelen en voorspellingen. Een klassiek voorbeeld is de groei van

BNP(bruto nationaal product) in relatie met aantal internet

verbindingen, of toename van de levensverwachting bij groei van BNP

en budget gezondheidszorg. Mobile banking en het effect op de

economie is een andere hot topic.

Met

een simpel lineair model zoals regressie, zijn gemakkelijk

voorspellingen te doen. Met een behoorlijke foutenmarge, afhankelijk

van de data. Echter het idee van voorspellen op grond van een model

is zo snel inzichtelijk te makente maken.

Gezichtsherkenning

De

praktijk is een stap verder. De NYTimes berichtte onlangs dat het

mogelijk was data van openbare surveillance camera's te gebruiken en

de beelden te draaien op foto-herkennings-software van Amazon:

https://www.nytimes.com/interactive/2019/04/16/opinion/facial-recognition-new-york-city.html

. Niet zo moeilijk en de kosten waren zeer beperkt! Dit artikel is

een van een reeks over

privacy(https://www.nytimes.com/interactive/2019/opinion/internet-privacy-project.html?action=click&module=Opinion&pgtype=Homepage

) en toont op verschillende manieren aan hoe onze privacy onderdruk

staat. Het toont ook aan dat Machine Learning, Articial

Intelligence(AI), niet alleen voor datascientist is. Herkennen van

plaatjes, stemherkenning, muziekherkenning etc. zijn modules die

volop in gebruik zijn. Ook kun je zelf met wat meer kennis nieuwe

modellen bouwen voor het maken van voorspellen. Google speelt een

belangrijke rol bij de ontwikkeling van deze deep learning software,

zoals TensorFlow, dat als open source ter beschikking wordt gesteld.

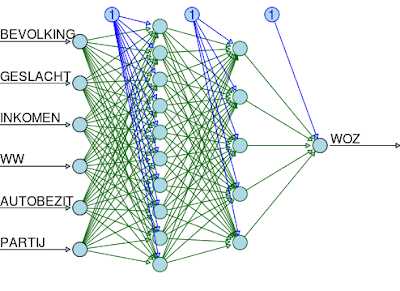

Tensorflow

voor het schatten van WOZ op grond van 6 andere variabelen(

https://www.kaggle.com/peterverweij/kernel-tensorflow-woz

)

Nederlandse

gemeenten

Laten

we eens een voorbeeld nemen dichter bij de datajournalistiek:

Nederlandse Gemeenten en de politieke kleur van de burgemeester.

Hier is de struktuur van de datamatrix:

'data.frame': 415 obs. of 12 variables: $ ID : int 0 1 2 3 4 5 6 7 8 9 ... $ GEMEENTE : Factor w/ 415 levels "'s-Gravenhage",..: 3 4 5 6 7 8 9 10 11 $ BEVOLKING : num 25721 12746 30446 27299 28070 ... $ GESLACHT : Factor w/ 2 levels "m","v": 1 1 1 1 1 1 1 1 1 2 ... $ BURGEMEESTER : Factor w/ 413 levels "Aaltina Evenhuis-Meppelink",..: 95 102 $ PARTIJ : Factor w/ 7 levels "CDA","CU","D66",..: 5 1 7 1 2 5 7 1 7 $ GEM_INKOMEN : num 13400 12500 14700 11900 11400 12300 15100 13200 11900 $ GEM_WOZ : num 255000 277000 301000 223000 196000 217000 277000 196000 $ WW_PER_100 : num 19 10 12 17 21 11 11 14 23 18 ... $ AUTOBEZIT : num 488 470 499 460 448 ...

Deze (oude) data zijn een combinatie van 'kroonbenoemde benoemde

burgemeesters' en het scrapen van data van wikipedia pagina's van

Nederlandse gemeenten. Het begint natuurlijk met beschrijvende

statistiek, de verdeling op de verschillende variabelen, zoals

hoeveel mannen/Vrouwen welke partij levert de meeste burgemeesters

etc.

Dan

het analytische deel: de verbanden: is er een verband tussen

geslacht en politieke partij? Of wel een procentuele vergelijking in

een kruistabel, of een Chi-kwardraat laat zien of er een verband is.

Inkomen

en WOZ-waarde ligt voor de hand: Pearson correlatie geeft de sterkte

van de samenhang. Een regressielijn en een scatterdiagram

visualiseert dit verband.

Voorspellen

en categoriseren

Op

grond van de regressie is een lineair model te maken een daarmee de

WOZ waarde te voorspellen op grond van inkomen. En verder? Eigenlijk

is de dataset te klein voor deep learning; desondanks geeft het een

indruk van de mogelijkheden.

1.

Kunnen we ook verschillende soorten gemeenten onderscheiden; groepen

van gemeenten? Met behulp van bijvoorbeeld K-Means lukt het on grote

steden als een afzonderlijk groep te benaderen. rijk en arm, hoge en

lage werkloosheid, lukt minder omdat de data toch te dicht bij elkaar

liggen.

2.

Kunnen we ook de politieke kleur van de burgemeester of het geslacht

voorspellen op grond van de andere variabelen? Met een model

gebaseerd op 'Random Forest' (een model gebaseerd op Decision Trees)

lukt dat heel aardig, binnen een foutenmarge.

3.

Een tenslotte is de WOZ waarde te voorspellen op grond van de andere

variabelen? Met Tensorflow en Keras geeft ook dit model een aardige

voorspelling; na wat fine tuning daalde de fout van 253923 tot 34217.

Keras is een API voor TensorFlow. TensorFlow van Google is een open

source software voor machine learning gebaseerd op de idee van een

'neural network'.

Deze

simpele voorbeelden laten zien dat machine learning software ook in

de data journalistiek een toepassing vindt. Voldoende om wat meer

onderzoek te verrichten naar de mogelijkheden. De datajournalist

wordt een beetje datascientist. Geen pensioen; voorlopig is er denk

ik nog genoeg te doen!

Noot

Peter

Verweij (peter@d3-media.nl), werkte als docent aan de SvdJ te Utrecht

en is nu consultant en trainer datajournalistiek in Afrika.

Wie

geinteresseerd is in de berekeningen bij het bovenstaande

voorbeelden: volg mijn (datasets en) kernels op kaggle.com:

https://www.kaggle.com/peterverweij/kernels

.

Voor

meer achtergronden over machine learning, over kaggle.com: zie

verschillende postings op mijn blog https://d3-media.blogspot.com/

.

Geen opmerkingen:

Een reactie posten

Opmerking: Alleen leden van deze blog kunnen een reactie posten.